LUSRdisentanglement

LUSR番外篇(为什么Cycle Consistency VAE可以学习到领域一致表示augmentation)

Cycle Consistency VAE希望解决的问题

原始VAE将整个图像输入整个编码到Latent Space,Cycle Consistent VAE希望使用非对抗的训练方法获取数据的更一般表示(Specific/unspecific Latent Space)

Background

Cycle-Consistency

变量的解耦表示(Disentangle Representation of Variable)

Reference

Intuition

获取变量的解耦表示有两个动机,其一是让latent space具有可解释性,其二是希望利用解耦表示进行Domain generalization。

Method

Forward Cycle

给定两个Label相同的image $x_1,x_2$,编码器编码为

$f_z$编码为高斯分布,$f_s$是简单神经网络,前者获得Uniform Embedding,后者获得数据的Specific Embedding

重构

损失函数记作

这种情况下容易产生瑞华情况,即Decoder完全依靠Uniform Embedding退化为

一种做法是增添一个Discriminator用于保证$s_i$的可区分性

Reverse Cycle

Reverse Cycle为了解决退化提出的,具体做法是从z的先验分布中采样Uniform Embedding

给定两个Specfic Embedding $s_1,s_2$,这两个Embedding不必来自相同Label的数据,利用相同Uniform Embedding在不同Specific Embedding下Decode出的重构图像

希望$f_z(x_1^\prime) \approx f_z(x_2^\prime)$,这样做保证了Uniform Embedding在不同映射下的不变性,可以理解为Uniform Embedding产生路的位置而Specific Embedding产生背景色块

Experiment

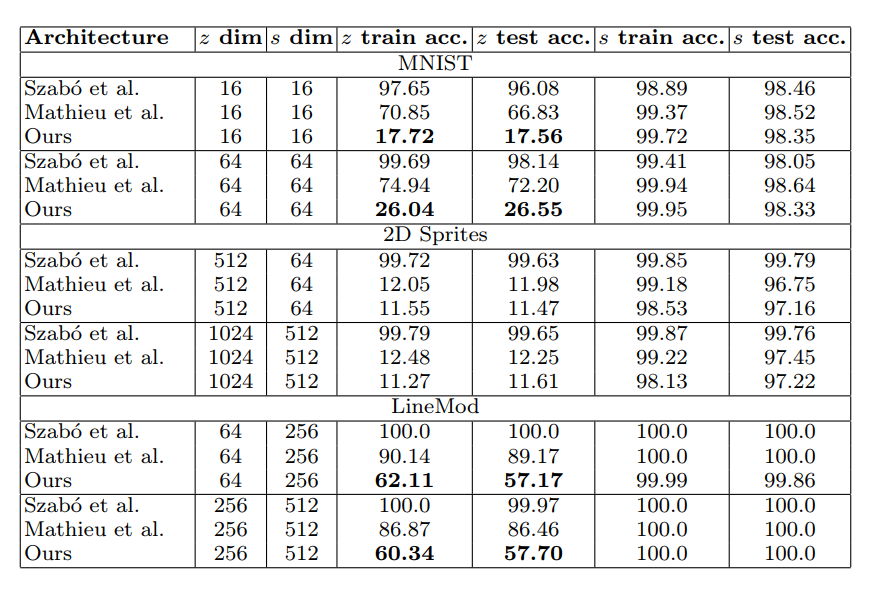

实验中比较让人感兴趣的一点是如何评价生成表示解耦性的好坏,作者基于生成的Specific/UnSpecific Embedding训练了两个分类器并进行validate,显然前者希望尽可能区分,后者则相反,实验表明利用这种方法得到的可区分性超过了现有baseline

实验证明了这种方法对于不同配置的z和s维度都是鲁棒的