Information Measures of Discrete Systems

Information Theory(Information Measures of Discrete Systems)

随机事件E信息量$\Tau(E)$的衡量满足三个条件

- 是随机事件E发生概率$Pr(E)$的单调递减函数

- $T(E)$是$Pr(E)$的连续函数

- 独立事件$E_1,E_2$交集的量度等于两者量度之和$T(E_1\bigcap E_2) = T(E_1)+T(E_2)$

- $T(E)\geq 0$,了解一个事件不会让不确定度降低

唯一符合以上公设的数学形式写成

$c,b>0$

启发启发启发启发启发,显然概率越小的事件发生价值越大

Entropy视为事件发生的信息量的期望

介绍一些数学结论

Upper Bound of Entropy

Uniform的概率分布entropy最大

Log-sum inequality

prove

Joint Entropy刻画了多个随机变量的信息增益

Conditional Entropy定义类似,给定发送端数据X条件下,接收端得到的信息增益

Chain Rule

共有信息量=发送端信息量+传输端条件信息量

考虑三者传输

1 | graph LR |

满足

Side Information告诉我们引入一个新的conditional side information不会让系统不确定性增加

同理

Mutual information用于表示H(Y|X)和H(X|Y)的交集

$I(X;Y )= 0$代表X和Y相互独立,这代表我们的信道不能正确传输信息(信道能传送的信息)

考虑多个输出端的情况

X同时送给Y和Z,满足

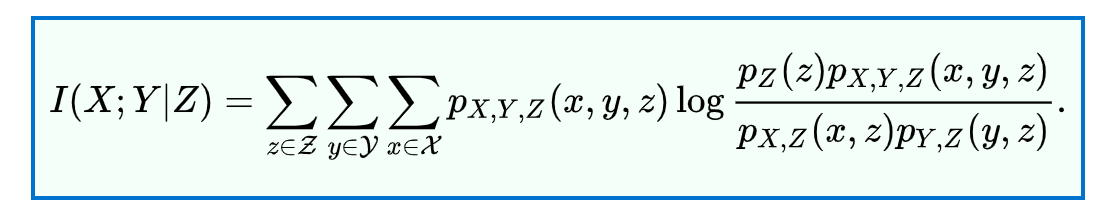

以上用到了条件互信息,可以写成

显然可以拆分成

扩展到多到一的场景

Entropy也遵循类似的Chain Rule

同理考虑多对多的传输

取等号满足

时序上互相独立

一起传输不如一对一传输的效率高